|

|

今天给大家分享两篇TVCG 2021和NeurIPS 2019上探究情感可解释性的论文。第一篇论文提出了一个交互式视觉分析系统,用于可视化和解释多模态情感分析模型;第二篇论文基于概念归因的方法来进行模型决策的解释。

分享作者:张腾甘、孙雷

1. M2Lens: Visualizing and Explaining Multimodal Models for Sentiment Analysis

发表期刊:TVCG 2021

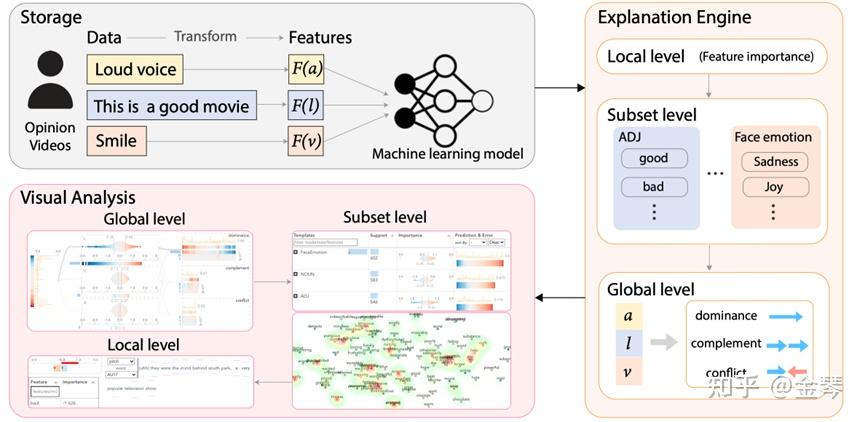

本文提出了一个交互式视觉分析系统M2Lens,用于可视化和解释多模态情感分析模型。该系统提供了global、subset和local层级的模态内和模态间的交互解释,使得能够从不同的层级来理解多模态情感分析模型。M2Lens由存储模块、解释引擎和可视化分析界面组成(如图1), 首先对用户的视频抽取视觉、音频以及文本模态的特征并输入到机器学习模型进行训练,然后在解释引擎基于特征属性的办法生成多层级的解释,最后通过可视化分析界面从五个主要视图对解释进行可交互的探索。

图1 M2Lens由存储模块、解释引擎和可视化分析界面组成

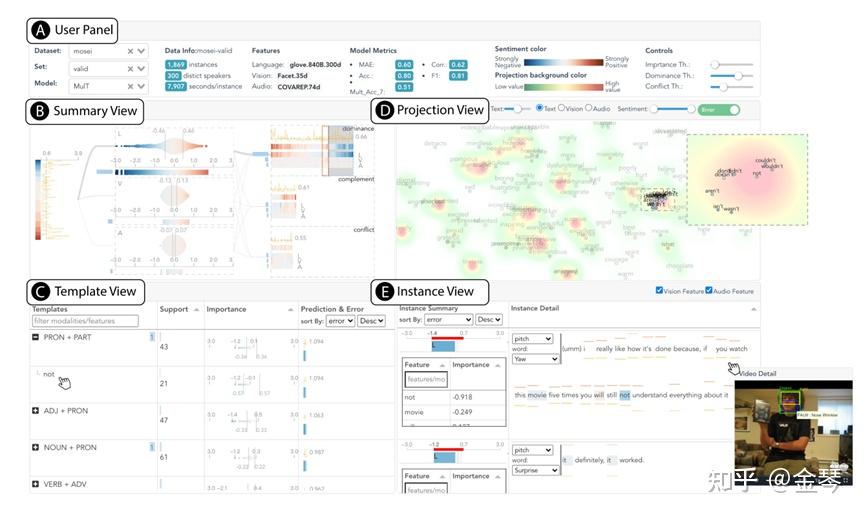

M2Lens的可视化分析界面如图2所示,分别由用户面板、摘要视图、模板视图、投影视图和实例视图组成。本文还对Multimodal Transformer[1]和EF-LSTM[2]进行了案例研究,并且进行专家访谈收集了对系统工作流程、系统设计、应用场景和改进建议的反馈,证明了该系统对于帮助用户深入了解多模态情感分析系统的有效性。

图2 M2Lens的可视化分析界面

[1] Y.-H. H. Tsai, S. Bai, P. P. Liang, J. Z. Kolter, L.-P. Morency, and R. Salakhutdinov. Multimodal transformer for unaligned multimodal language sequences. In Proceedings of the 57th Annual Meeting of the Association for Computational Linguistics, pp. 6558–6569, 2019.

[2] S. Hochreiter and J. Schmidhuber. Long short-term memory. Neural Computation, 9(8):1735–1780, 1997.

2. Towards Automatic Concept-based Explanations

发表会议:NeurIPS 2019

本文采用基于概念归因的方法[1]来进行模型决策的解释,创新之处在于提出了可以自动抽取视觉概念的算法ACE(Automatic Concept-based Explanation),而[1]中是人手动选取的图片作为某一概念。

该算法属于事后可解释方法和全局方法,需要一个训练好的图片分类模型和某一个类别的图片集合作为输入,通过ACE算法自动抽取图片集中的概念,然后基于TCAV的方法[1]求得每一视觉概念对于判断该类别的重要性。

本文先是提出了基于概念的解释应该满足的3个要求:

1. 意义性:作为概念的图片对人类应该是有意义的

2. 一致性:作为某一概念的图片应该是相似的,与其他概念的图片应该有很明显的差异

3. 重要性:应该选用对预测类别有用的概念作为输入。比如对于图像分类,背景图片不应该作为判断类别的依据。

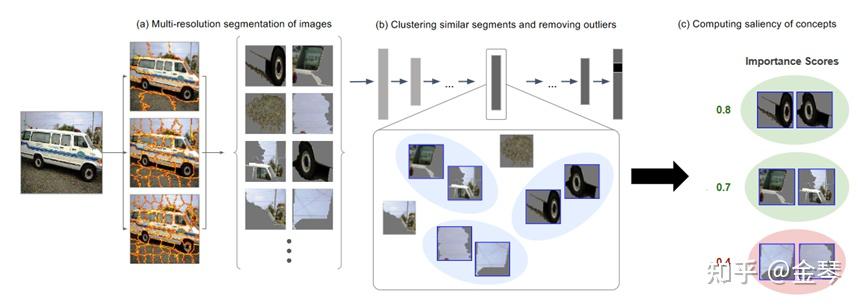

图1 ACE算法流程

ACE算法分为3步:

1. 图片分割

ACE使用SLIC超级像素分割方法,由于该方法计算速度快,性能好。作者在实验中使用了三种不同的分辨率来捕捉三个层次的纹理、物体的组成部分和整个物体。

2. 聚类和去除异常值

将相似的片段作为同一概念进行分组,为了衡量相似度,使用在ImageNet 数据集上训练的Inception-V3模型中mixed_8层中的值,通过计算欧氏距离作为相似度指标。每个聚类中与聚类中的片段相似度低的离群片段被移除。

3. 计算重要性得分

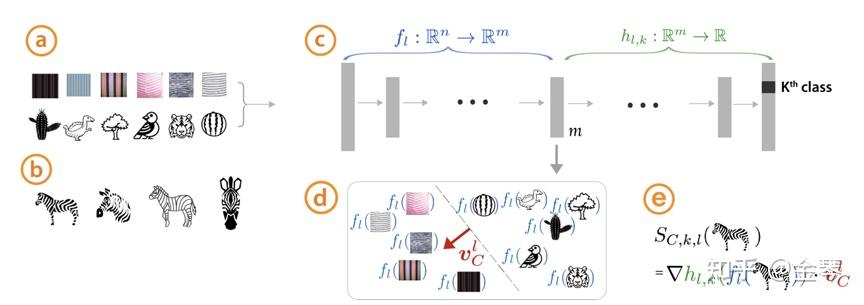

重要性得分采用了[1]中TCAV的计算方法。如图2,研究条纹概念对于斑马分类器的影首先收集一些条纹图片和各种随机图片作为训练数据集,然后简单训练一个线性模型(图d)。然后找到一个和分类平面垂直的法向量即为概念向量 v_{c}^{l} (图d的红色箭头)。概念向量 v_{c}^{l} 表示一张图片的“条纹度”。越靠近边界线的图片越不“条纹”,反之顺着箭头方向越深就越“条纹”。

图2 TCAV算法图

参考文献:

[1] Kim B , Wattenberg M , Gilmer J , et al. Interpretability Beyond Feature Attribution: Quantitative Testing with Concept Activation Vectors (TCAV):, 10.48550/arXiv.1711.11279[P]. 2017. |

|